近日,半导体分析机构 SemiAnalysis 发布的一份报告在 AI 领域引发轩然大波。该报告指出,此前被广泛报道的 DeepSeek V3 模型仅用 600 万美元训练成本的说法严重不实,其实际成本高达 13 亿美元。这一消息瞬间成为行业焦点,引发了人们对 AI 模型训练成本的重新审视以及对 DeepSeek V3 背后故事的深入探究。

DeepSeek V3 的 “成本迷雾”

一直以来,DeepSeek V3 以其 “低成本高产出” 的形象出现在大众视野。当整个硅谷乃至国内民众都在为 “仅用 600 万美元训练出匹敌 GPT-4o 的 AI 模型” 而兴奋不已时,SemiAnalysis 的报告犹如一颗重磅炸弹,打破了这一美好幻想。

据该分析机构称,所谓的 600 万美元仅仅是最终训练阶段的 GPU 电费账单,而资本支出和研发成本被完全忽略。在模型训练这座 “冰山” 之下,隐藏着巨大的烧钱黑洞。其中,1.3 亿美金用于服务器基建,9.44 亿美金花在了集群运维上。若将这些成本全部计算在内,DeepSeek V3 的实际开支直接飙升至 10 亿美元量级。

DeepSeek V3 的技术实力与行业影响

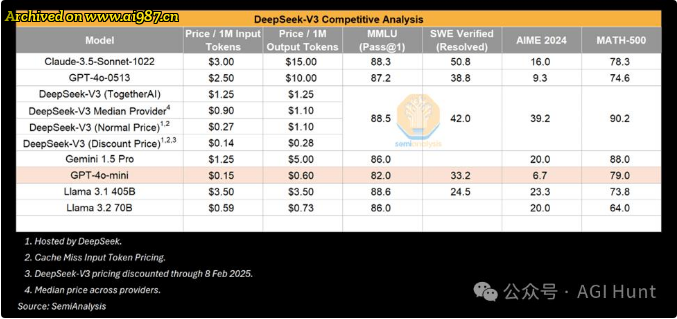

DeepSeek V3 在技术层面确实有着亮眼的表现。它基于创新的混合专家(MoE)架构,拥有 6710 亿个总参数,每个 token 激活 370 亿个参数,在各种基准测试中都展现出了顶尖的性能。同时,它具备高效的推理能力,尽管模型规模庞大,但通过创新的架构设计,依然能够保持良好的运行效率。那DeepSeek的多头潜在注意力机制(MLA) 则是实打实的硬核技术创新和突破了。

在功能上,DeepSeek V3 经过 14.8 万亿高质量 token 的预训练,在数学、编码和多语言任务等多个领域都有着卓越的表现。其 128k 的上下文窗口,能够有效地处理和理解大量的输入序列,为用户提供更加精准和全面的回答。此外,它还采用了先进的多 token 预测技术,进一步提升了性能和推理速度。

DeepSeek V3 的出现,在行业内掀起了一阵波澜。它让人们看到了在 AI 领域,即使面临诸多限制,一家资金充足、重点突出的初创公司也有可能推动技术的边界。当 OpenAI 前脚展示完 o1 模型的推理能力,DeepSeek 后脚就掏出 R1 模型叫板对标,甚至在某些方面实现了反超。这无疑给 AI 行业注入了新的活力,加剧了行业竞争。

然而,细看 DeepSeek V3 的论文也会发现一些问题。例如,R1 的算力消耗被打码,合成数据生成和强化学习需要的大量 GPU 资源也被刻意隐藏。这不禁让人对其真实的算力情况产生怀疑,也为此次成本争议埋下了伏笔。

争议背后的行业格局与发展趋势

这场成本争议不仅仅关乎 DeepSeek V3 本身,更暴露出 AI 军备竞赛背后的残酷真相。一方面,小模型逆袭的神话,本质上可能是巨头们的技术溢出。有消息称,DeepSeek 的 R1 模型被扒出大量使用 GPT-4 生成的数据,OpenAI 的法务团队甚至已磨刀霍霍准备起诉。这一事件不仅让 DeepSeek 陷入了舆论漩涡,也让人们对 AI 模型的数据来源和合规性产生了更多的关注。

另一方面,随着美国收紧芯片出口管制,DeepSeek 的算力底牌成为了人们关注的焦点。目前,它主要依靠提前囤积的 1 万张 A100 显卡,但面对禁售令的不断升级,中国团队不得不使用特供版 H20 芯片。然而,性能缩水后的 H20 芯片能否满足 DeepSeek V3 后续的发展需求,还是未知数。或许在未来,DeepSeek V3 只能寄希望于 “算法优化能解决一切”。

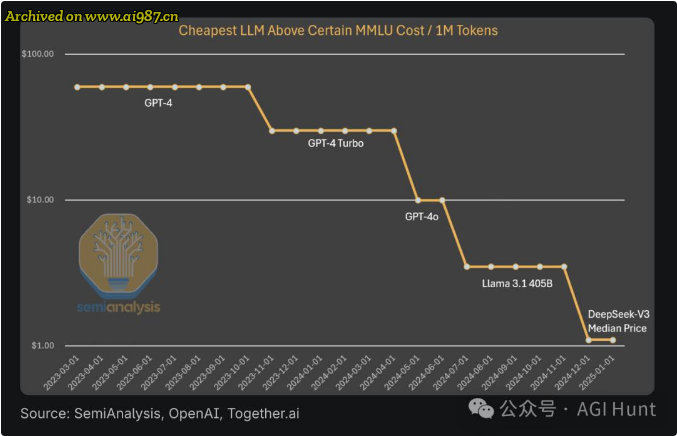

此外,行业内还面临着算法进步与硬件消耗的 “死亡交叉”。SemiAnalysis 预测,年底推理成本还将再降 5 倍,但代价是需要吞噬更多的算力资源。当 Anthropic CEO 达里奥说出 “10 倍算法进步抵得上 100 倍算力增长” 时,也反映出在 AI 发展过程中,算法与硬件之间的复杂关系。

而 DeepSeek V3 的成功也证明了一个重要趋势,即一个专注且资金充足的初创公司,完全有能力在 AI 领域取得突破。在这场始于成本争议的风暴中,我们看到了中美之间、开源与闭源之间等多方的角力。当这些闭源 AI 实验室还在为 “是否该相信中国公司的技术报告” 吵得不可开交时,DeepSeek 已经默默更新了招聘页,高薪诚聘 GPU 芯片架构师,展现出其在技术研发上的决心和野心。

出处:头条号 @人工智能学家