据 ai987.cn 于 2025 年 10 月 14 日收到的消息 ‣ 走进典型数据中心,首先映入眼帘的是成千上万个风扇的低沉嗡嗡声。但随着人工智能算力爆发,传统风冷系统已难以应对。过去十年,先进芯片功率密度呈爆炸式增长,英伟达V100 GPU功耗300瓦,A100达到400瓦,H100高达700瓦,最新Blackwell GPU功耗达1200瓦。液冷公司Mikros Technologies总裁Drew Matter表示,未来芯片功耗将超2000瓦,行业正为5千瓦以上芯片做准备。

人工智能是能源消耗的主因,导致机架功率密度从8千瓦飙升至100千瓦。数据中心行业普遍认为,液体冷却成为高端AI设施的必然选择。水的比热是空气四倍,导热系数是空气23.5倍,冷却效率显著提升。

目前主流技术分四种:单相直接芯片冷却采用水循环系统,金属冷板直接覆盖高热芯片;两相直接芯片冷却利用特殊介电流体沸腾吸热,避免温度升高;单相浸入式冷却将服务器整体浸入介电流体;两相浸入式冷却则通过沸腾液体实现更高效率。科慕公司研究显示,两相浸入式冷却在弗吉尼亚州阿什本的十年总成本比单相方案低300万美元。

Accelsius公司表示,两相冷却流速仅为单相的五分之一,能耗更低。Airedale公司则开发了蒸汽层隔离技术,解决维护难题。行业共识是,AI算力持续增长将驱动冷却技术快速迭代。

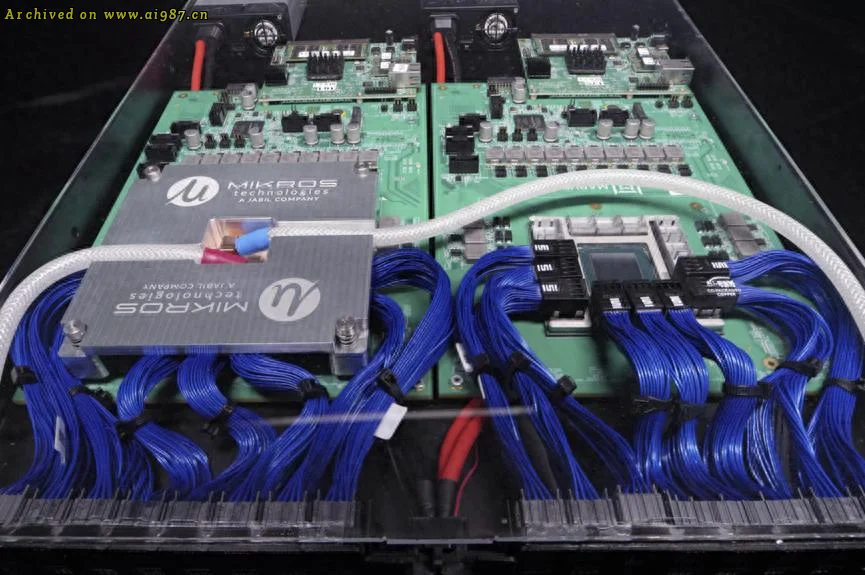

Mikros Technologies等公司正在研发单相直接芯片液冷技术。在这项技术中,将一块冷却板放置在最热的芯片上方。液体在冷却板中循环流动,带走热量

Accelsius等公司正在提出两相直接芯片液冷技术。在这种技术中,最热的芯片顶部也放置了一块冷却板,流经冷却板的液体直接在芯片顶部沸腾

采用浸入式冷却,所有部件都由同一种液体冷却。油带走热量后,有多种方法可以冷却浸入式液体。Bielstein解释说,Baltimore Aircoil设计了一种热交换器,使设施用水在水箱内的线圈和板片之间循环

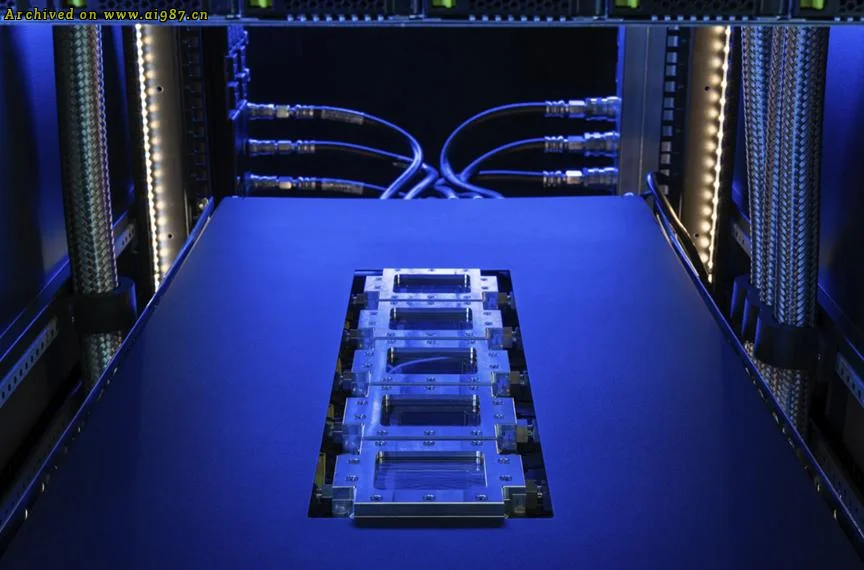

在位于特拉华州纽瓦克的实验室里,科慕团队正在研发一种特殊配方的液体,用于两相浸入式冷却。在这种方法中,服务器被浸入一桶液体中,液体在高温组件上方沸腾,从而冷却系统

综合自网络信息